سرور مجازی هند

خرید سرور مجازی هند: ارائه سرور مجازی لینوکسی از کشور هند، مناسب برای عبور از تحریم ها، تریدر ها، دولوپرهای گوگل، سایتهای بانکی و .. با کانفیگهای متنوع.

ویژگی های سرور مجازی هند:

سرور های مجازی هند مجهز به هارد SSD هستند، که باعث افزایش کیفیت، سرعت و کارایی سرور های مجازی می شود . سرورهای مجازی هند دارای پلن های متنوعی هستند که شما میتوانید براساس نیاز خود آن را انتخاب کنید. سرورهای هند ما ایده آل برای میزبانی از سرورهای وب، پایگاه های داده و استفاده به عنوان سرور مجازی بایننس و ترید هستند که میتوانید از آن به عنوان آی پی ثابت برای بایننس و دیگر صرافی ها استفاده کنید. همه سرورها به پورت 1Gbps متصل هستند.

هنگام خرید سرور مجازی هند امکان نصب برخی از توابع پر طرفدار لینوکس قابل نصب میباشد که در حین سفارش امکان انتخاب سیستم عامل مورد نظر میسر است.

پلن های سرور مجازی هند

| مشخصات | A1 | A2 | A3 | A4 |

|---|---|---|---|---|

| CPU/پردازنده | 1vCore | 1vCore | 2vCore | 2vCore |

| RAM/حافظه | 768M | 1024M | 2048M | 4096M |

| HDD/هارد دیسک | 20G | 30G | 40G | 20G |

| نوع هارد دیسک | SSD | SSD | SSD | SSD |

| نوع مجازی ساز | KVM | KVM | KVM | KVM |

| Port/پورت | 1Gbps | 1Gbps | 1Gbps | 1Gbps |

| BW/ترافیک | 750GB/M | 1.5TB/M | 2TB/M | 2.5TB/M |

| DC/دیتاسنتر | قابل سفارش از 43 کشور | قابل سفارش از 43 کشور | قابل سفارش از 43 کشور | قابل سفارش از 43 کشور |

| OS/سیستم عامل | Linux | Linux | Linux | Linux |

| زمان تحویل | 1-24 hours | 1-24 hours | 1-24 hours | 1-24 hours |

| آپ تایم | %99.99 | %99.99 | %99.99 | %99.99 |

| پشتیبانی | ||||

| ماهیانه/تومان | 402,000 | 625,110 | 940,680 | 1,149,720 |

| سفارش | سفارش | سفارش | سفارش |

پلــن مورد نظرتـــان را نیــافتید؟!

همین حالا پلن انتخابی یا کانفیگ اختصاصیتان را درخواست کنید

پشتیبانی 24/7

وان سرور با تیمی قدرتمند پشتیبانی 24 ساعته در هفت روز هفته را برای کاربران گرامی وان سرور تدارک دیده تا در هر زمان افتخار خدمت رسانی داشته باشد. پشتیبانی از طریق تیکت و تماس.

آپتایم 99.99%

سرورهای وان سرور از معتبرترین دیتاسنترهای جهان که دارای تضمین آپ تایم 99.99% میباشند، تیم وان سرور به صورت 24 ساعته در حال مانیتورینگ سرورها هستند تا در صورت وجود هرگونه اختلال و مشکل سریعا پیگیر حل مشکل باشند.

مجازی ساز KVM

میزبانی سرورهای مجازی در کنترل پنل Virtualizor امکان دسترسی مدیریتی بهتر با قابلیت نصب و مدیریت سیستم عامل را به شما میدهد که مناسب افرادی با کاربردهای آموزشی میباشد.

هارد NVMe

پرسرعت ترین هارد تا لحظه حال از نوع ssd Nvme میباشد که با اختلاف زیادی از رقبای نوع دیگر هاردها انتقال دیتا دارد، انتقال دیتا با سرعت تقریبا 8GB/s تجربه کاربری بهتری را در مجازی ها به نمایش میگذارد.

سیستم عامل لینوکس

این نوع سرورها به دلیل دیتاسنتری بودن، فقط به نصب سیستم عامل های لینوکس محدود هستند. امکان نصب اکثریت توابع پر مخاطب لینوکس در این سرور محیاست.

ارائه IPv4

هر سرور مجازی دارای یک آی پی اختصاصی از نوع IPv4 از همین کشور میباشد که تا زمان لغو سفارش در اختیار شماست.

سوالات متداول

برخی از سوالاتی که ممکن است در ابتدا داشته باشیدبله؛ این سرورها کنترل پنل مدیریتی دارن که میتوانید برخی از توابع لینوکس را بدون نیاز به درخواست پشتیبانی نصب کنید.

منابع سخت افزاری گفته شده در هر پلن کاملا اختصاصی در اختیار کاربران قرار میگیرد.

بله، فقط امکان ارتقای پلن در صورت موجود بودن در هر بازه زمانی ممکن است و محاسبه هزینه ارتقا بر اساس زمان مانده و تفاوت قیمت دو پلن میباشد . در این خصوص میتوانید از طریق تیکت درخواست ارتقاتون رو به پشتیبانی ارسال کنید.

به دلیل دیتاسنتری بودن سرورها قابلیت ارتقای ترافیک نیست، تنها راه افزایش ترافیک ارتقای سرویس به پلن بالاتر میباشد. توجه داشته باشید که ترافیک سرور ها در بازه زمانی 30 روزه به صورت خودکار 0 میشود.

به دلیل دیتاسنتری بودن سرورها امکان ارتقای بخشی منابع ممکن نیست! در صورت ارتقا میتوانید پلن سرورتون رو به پلن بالاتر ارتقا بدهید. امکان تغییر آی پی هم میسر نیست.

اگر جواب سوالتان را نیافتید، میتوانید از لینک زیر در بخش تماس با ما از طریق پلهای ارتباطی با ما در ارتباط باشید.

نظرات مشتریان

Ali es

“ از دامین و هاست استفاده میکنم. تقریبا همه چیز عالی است اما در تبلیغات در مقایسه با رقبا مثل ایران سرور کم کاری میکنید. اما اگر بتوانید تبلیغات خود را مانند سایت ایران سرور افزایش دهید خیلی مشتری جذب میشود. با اطمینان سرویس شما از ایران سرور بهتر است اما آنها تبلیغات گسترده ای در آژانس های تبلیغاتی اینترنت دارند ”

shahrekord-team

“ از سرور مجازی هلند استفاده میکنم. از سایت و پشتیبانی راضی هستم. ”

bitanik system

“ از سرور های مجازی مدیریت شده استفاده میکنم. کیفیت سرور ها بسیاز مناسب هست . پشتیبانی سایت هم حرف نداره . راضیم ”

امین

“ از سرورمجازی گرین آلمان استفاده میکنم. کیفیت عالی، قیمت عالی، پشتیبانی عالی ”

امیر

“ وان سرور را اگر بخواهم در یک کلمه توصیف کنم " بی نظیر " ، هم سرویس خوب ، هم قیمت مناسب و از همه مهم تر پشتیبانی عالی که در کمترین زمان با روی خوش همیشه پاسخگو هستید ، من از شرکت های دیگه هم سرور مجازی دارم و یک سرویس با یک مشخصات و از یک دیتا سنتر هم از شما داشتم و هم از یک شرکت معتبر دیگه که سرویس شما با اختلاف زیاد برنده بود و وقتی تیکت بهشون میزدم و میگفتم هیچ پاسخ درستی هم نمیتونستند بدهند ، امیدوارم همیشه این روحیه و پشتکاری که دارید و نتیجه آن رضایت مشتریانی مثل من هست که با خیال راحت و افتخار به دیگران معرفی کردم و میکنم را حفظ کنید. ”

واگریک

“ از سرور مجازی استفاده میکنم . در یک کلام پشتیبانی خوب و کیفیت عالی ”

جزیره آموزشی

برخی از پستهای آموزشی پیشنهادی

چند نکته مهم سئو برای تازهکارها

چند نکته مهم سئو برای تازهکارهاسئو همواره در حال تغییر استموتورهای جستجو همواره سعی دارند با ترفند و متدهای مختلف ، بهترین نتایج را در اختیار کاربران قرار دهند و بدین منظور دیده شده که سال به سال به هوشمندی موتورهای جستجو افزوده شده و الگوریتمهای آنها برای شناخت یک سایت کارآمد در حال تغییر است.پس بدانید که حداقل باید هر 3 الی 6 ماه یک بار وضعیت سئو سایت خود را کامل چک کنید و همیشه به دنبال مطالب بروزی که منتشر میشود ، باشید.بهینه سازی سایت شما ممکن است به تغییرات کلی سایت منجر شودممکن است سایت شما پس از مدتی کوتاه یا چند ساله ، نیاز به تغییرات زیادی داشته باشد تا از لحاظ کلی اصول سئو جدید در آن رعایت شود و یا به اصطلاح SEO Friendly باشد .زبانهای برنامه نویسی هر روزه پیشرفت میکنند و دیدگاه کاربران اینترنتی به سایتهای مدرن باعث میشود ، کاربران سایتهایی که از لحاظ ظاهری شرایط مدرن و مناسبتری را داشته باشند ، بیشتر به چشم آیند. پس بدانید که برای بهبود باید مدرن باشید و از شرایط جدید و متدهای جدید بهره ببرید.یک نکته مهم که در اینجا بسیار مهم است و باعث میشود گاهاً کاربران ایرانی متضرر گردند این است که برای طراحی وب سایت به افرادی که تجربهای در علم سئو ندارند ، مراجعه کرده و پس از اینکه وب سایت را تحویل گرفتند با یک فرد سئوکار مشورت و درخواست کمک میکنند و پس از بررسی سئو سایت متوجه میشوند ، کدها و دستورات آنقدر مشکلات دارد که گویی سایت باید به طور کلی بازنویسی شود و همین امر باعث هزینه بیشتر و از بین رفتن زمان کارفرما شود.سئو یک علم غیر قابل پیش بینی استتا به امروز ، هیچ فرمول خاصی وجود نداشته که یک شبه راه صد ساله را در سئو بپیماید و وب سایت شما را خیلی سریع به نتایج نخست نزدیک کند.شاید راههای میانبر زیادی وجود داشته که باعث شده شما پیشرفت کنید و خیلی سریع به صفحات اول گوگل دست پیدا کنید اما باید بدانید که این میابنرها غیر معقولانه بوده و حتی اگر از پنالتی شدن در سایت گوگل فرار کنید ، مطمئن باشید از صفحات جستجو به صورت آهسته و آهسته حذف خواهید شد.پس هیچ وقت به دنبال راهی برای اول شدن در مدت زمان کوتاه نباشید و همواره تلاش کنید تا با طی کردن پله به پله مواضع خود ، به پله اول برسید.بهینه سازی و بهبود سئو باعث افزایش فروش محصولات نخواهد شدبرخی از افرادی که شروع به فروش محصولات خود در سطح اینترنت میکنند یا خدمات خود را در اینترنت ارائه میکنند تصور این را دارند که با افزایش سئو و قرار گرفتن در بین صفحات اول گوگل ، فروش بهتری خواهند داشت.در صورتی که این طرز فکر کاملاً اشتباه است.شاید با قرار گرفتن در صفحات اول جستجو موتورهای گوگل و بینگ ، بتوانید کاربران زیادی را به سمت سایت خود بکشانید و برند خود را بیش از پیش برای کاربران اینترنتی آشنا سازید ، اما باید بدانید که نوع خدمات ، نحوه ارائه آن ، قیمتهای محصولات و گارانتی و ... در خرید کاربر نیز مؤثر است و تنها با ورود کاربر نمیتوانید محصول خود را صد در صد بفروشید.امروزه سایتهای زیادی در زمینه فروش قطعات کامپیوتر و تلفن همراه وجود دارند و هزاران کاربر هر روزه به سایت آنها مراجعه خواهند کرد ، آیا تمام مراجعه کنندگان خریدار هستند ؟شاید برخی از این افراد خریدار باشند و برخی تنها برای نگاه کردن محصولات به سایت شما بیایند.پس هیچگاه توقع نداشته باشید هر فردی که داخل سایت شما شد ، محصول شما را حتماً خریداری کند ولی نکته مثبت آن است که با محصولات ، خدمات و برند شما کاملاً آشنا خواهد شد.بهینه سازی و سئو همه چیز برای سایت شما نیست!شاید با سئو و بهینه سازی به موتورهای جستجو کمک کنید تا بهتر سایت شما را شناسایی کنند و کاربران را نیز به سمت شما مراجعه دهند ولی از زمانی که کاربران اینترنتی وارد سایت شما شدند ، بقیه کارها به عهده شما و سایت شماست.یکی از مهمترین نکات در بین چند نکته مهم سئو برای تازهکارها این است که بدانید گرافیک زیبا و مدرن ، ارائه محتوای مطلوب و مورد نظر کاربران ، کیفیت خدمات ارائه شده و صدها نکته دیگر است که کاربر را به سمت سایت شما جلب خواهد کرد و یک کاربر را به سایت شما وفادار میکند.تصور کنید یک سایت خبری دارید که از لحاظ طراحی و سئو در رتبه خوبی قرار دارد ؛ حال اگر اخبار زرد و دروغین منتشر کنید و پس از مدتی کاربران به ضعف شما و اخبار دروغین شما پی ببرند ، یکباره از رتبههای بالا سقوط خواهید کرد تا جایی که برند و سایت شما به عنوان یک سایت غیر معتبر خیلی زود از چشم کاربران افتاده و حتی اگر در صفحات اول گوگل هم باشید ، کاربران هیچگاه به سایت شما مراجعه نخواهند کرد.پس همه چیز را به سئو نسبت ندهید و همین الان برای کاربران هدف خود ، محتوایی مفید و مناسب تهیه کنید تا کاربران از ورود به سایت شما و خواندن مطالب شما لذت ببرند.

ادامه مطلب

آموزش نصب کلوکسو مستر Kloxo-MR در centOS 6

آموزش نصب کلوکسو مستر Kloxo-MR در centOS 6کلوکسو چیست؟!لوکسو یا LXAdmin تنها کنترل پنلی است که امکان استفاده از سرویس های lighttpd و DJBDNS را تنها با 8 مگابایت رم فراهم می کند که خود این کنترول پنل به تنهایی از 1 مگابایت رم سرور استفاده می کند .این کنترل پنل نیز مانند کنترل پنل های دیگر امکاناتی نظیر سرویس Mail ، اسپم فیلترینگ ، سرویس PHP ، CGI ، FTP ، MySql ، Perl ، Suexec و.... ارائه می دهداز امکاناتی که این کنترل پنل را نسبت به کنترل پنل های دیگر متمایز کرده است فایروال lxguard می باشد که باعث می شود شما از هرگونه حملات مخربی نظیر DOS و DDOS مصون بمانید.همچنین این کنترل پنل دارای سرعت فوق العاده بالایی می باشد و در پایه ریزی آن از ajax استفاده شده است . در ضمن این کنترل پنل رایگان می باشد و نیازی به خرید لایسنس ندارد . ( در ایران به دلیل محبوب بودن سی پنل کلوکسو زیاد استفاده نمیشود )این پنل به علت وجود برخی باگ ها مورد محبوبیت همگان واقع نمیشود، اما در ورژنهای جدید این برنامه خیلی از معایب ان برداشته شده ولی با درنظر گرفتن ایمنی بخش های امنیتی سرور و پنل و پورتها بهترین کارایی از این پنل را خواهیم داشت.توضیحاتی از شرکت سازنده در مورد پنل کلوکسو مستر ( kloxo MR ) :Supported OS’s : Redhat/CentOS 5 and 6 (32bit and 64bit) or their variantsBilling: AWBS, WHMCS, HostBill, TheHostingTool and AccountLab PlusWeb server: Nginx, Nginx-***** and Lighttpd-*****; beside Httpd and Lighttpd (in progress: Varnish, Hiawata, ATS and Httpd 2.4)Php: Dual-php with php 5.3/5.4 as primary and php 5.2 as secondary (in progress: multiple-php)PHP-type for Apache: php-fpm_worker/_event and fcgid_worker/_event; beside mod_php/_ruid2/_itk and suphp/_worker/_eventMail server: qmail-toaster instead special qmail (in progress: change from courier-imap to dovecot as imap/pop3)Database: MySQL or MariaDBWebmail: Afterlogic Webmail Lite, T-Dah and Squirrelmail; beside Roundcube and HordeFTP server: Pure-ftpdDNS Server: Bind, Djbdns and Powerdns (in progress)Addons: ClamAV, Spamassassin/Bogofilter/Spamdyke and RKHunterFixed many bugs of Kloxo Official (including security issues)And many more!در صورت نیاز به سرور با پنل کلوکسو به صورت رایگان کانفیگ مربوطه در اختیار شما قرار خواهد گرفت.و حال نصب کلوکسو:ابتدا وارد ssh سنت شوید و yum را آپدیت کنید:/ cdyum update -yپکیج های مورد نیاز را نصب می کنیمyum install yum-utils yum-priorities vim-minimal subversion curl zip unzip -yyum install telnet –ySelinux را غیر فعال می نمائیمsetenforce 0echo ‘SELINUX=disabled’ > /etc/selinux/configشروع به نصب می کنیمcd /etc/yum.repos.drepo مورد نیاز را دانلود می کنیمwget https://github.com/mustafaramadhan/kloxo/raw/release/kloxo-mr.repo –no-check-certificate/ cdyum install kloxomrsh /usr/local/lxlabs/kloxo/install/setup.shسوال پرسیده می شود که در حالت master نصب گردد یا slave که باید master را انتخاب کنیدپس از نصب ریبوت می کنیم و از آدرس زیر وارد پنل می شویم:http://yourip:7778User: adminPass: adminhttps://yourip:7777User: adminPass: adminامیدوارم این آموزش وان سرور مفید واقع شده باشد.

ادامه مطلب

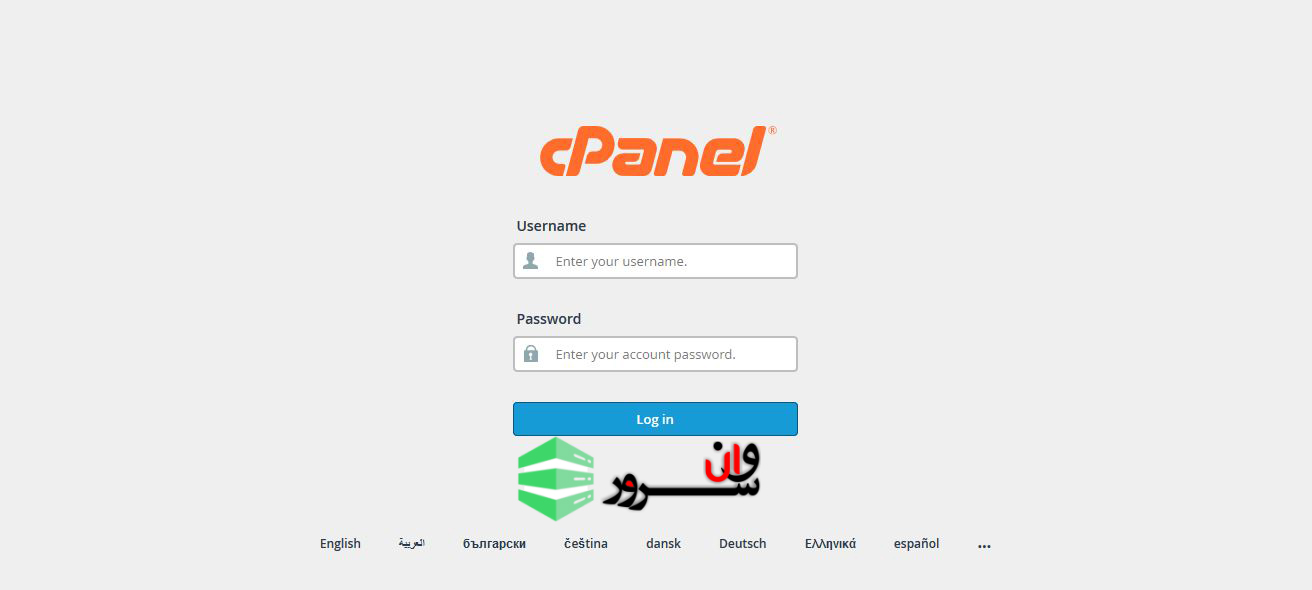

آموزش افزودن دامین در سی پنل (Cpanel)

آموزش افزودن دامین در سی پنل (Cpanel)اگر دامنه جدیدی خریداری کرده اید و می خواهید از آن در وب سرور خود استفاده کنید ، ابتدا باید دامنه را به وب سرور خود اضافه کنید. اما قبل از آن ، باید اطمینان حاصل کنید که DNS دامنه از قبل به سرور وب شما ست شده شده است. در این مقاله به آموزش افزودن دامین در سی پنل (Cpanel)میپردازیم. افزودن دامین در سی پنلبرای افزودن دامین جدید به سی پنل مراحل زیر را دنبال کنید:لاگین کردن در Cpanelدر سی پنل خود همانند تصویر زیر لاگین کنید. توجه داشته باشید که از نام کاربری و پسوردی که دریافت کردید استفاده کنید.رفتن به قسمت Addon Domainsدر cpanel خود و در بخش Domains بر روی Addon Domains کلیک نمایید.افزودن دامیندر جای خالی نام دامنه جدید را وارد کنید. نام FTP و دایرکتوری به صورت خودکار ایجاد می شوند. برای حساب نیز یک پسورد انتخاب کنید.بعد از پر کردن اطلاعات بر روی دکمه ی Add Domain کلیک نمایید.موفقیت آمیز بودن کار و نتیجهو در آخر پیامی با عنوان موفقیت آمیز بودن ایجاد دامین جدید ظاهر میشود.در صورت داشتن سوال و یا بروز مشکل در افزودن دامین جدید در Cpanel با بخش پشتیبانی در ارتباط باشید.

ادامه مطلب